- 2018-9-25

- 3DCAD・3DCG, 最新情報

- 3D, 3DCG, 3DPrinting, 3Dプリンティング, 3Dモデリング, テクノロジー

研究者はラフな2Dスケッチから3Dサーフェスモデルを生成するアルゴリズムを開発

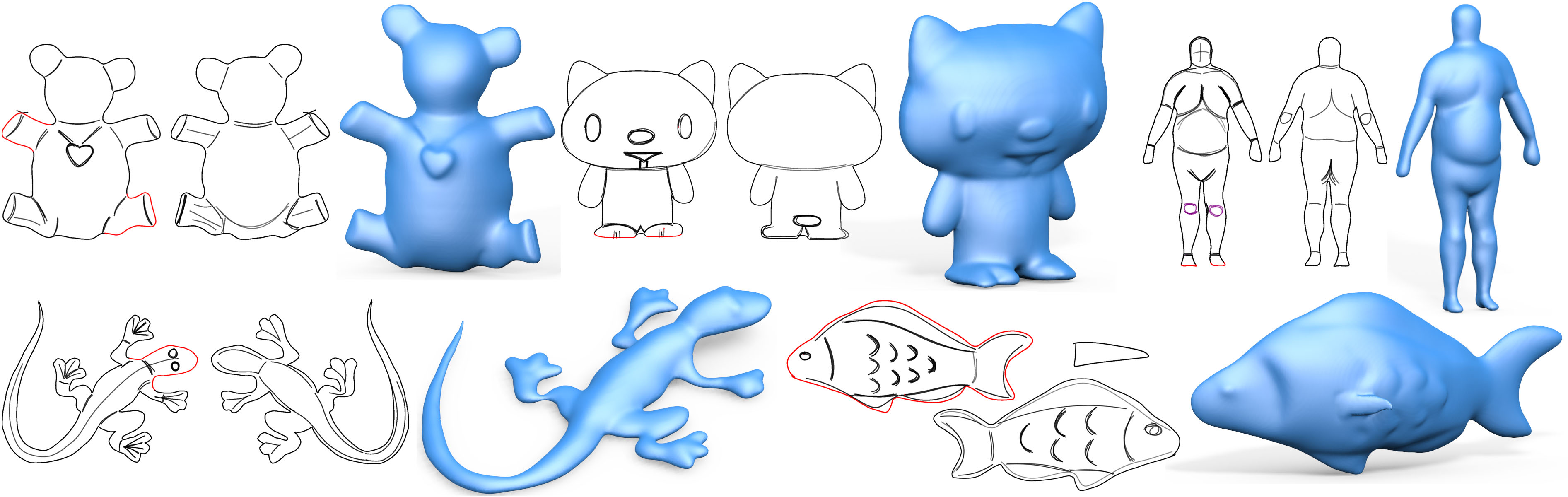

香港大学、 Microsoft Research Asia、 ブリティッシュコロンビア大学の研究者等から構成された研究チームは、CNN(convolution neural network/畳み込みニューラルネットワーク)を用いて、フリーハンドスケッチから3Dサーフェスをモデリングする手法を開発し、SIGGRAPH Asia 2018で発表した。

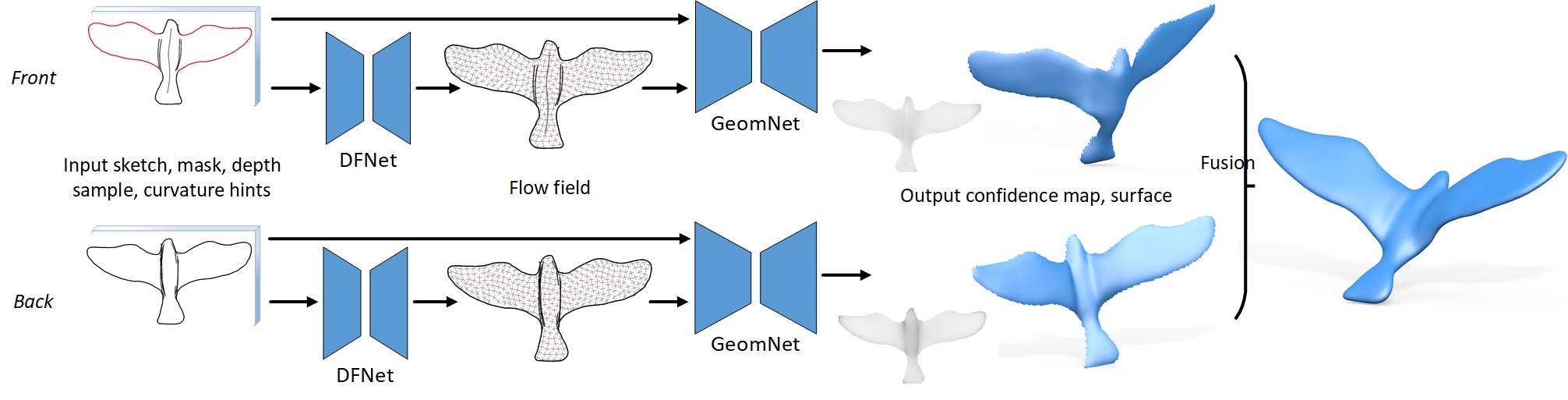

このシステムでは、サーフェスを表す法線マップと深さを推測するためにCNNを使用し、2Dドローイングで描かれた線描からDFNetを用いて表面の曲率方向や流れを特徴付け、GeomNetを用いて深度マップおよび法線マップとして表される表面パッチを生成。背面図に当たるスケッチは、正面図から輪郭の深さをコピーし、表面と同じ2段階のCNNを経てバックパッチを生成する。

こうして生成された2つの表面パッチは最終的に結合され、完全な3D形状へ融合される。

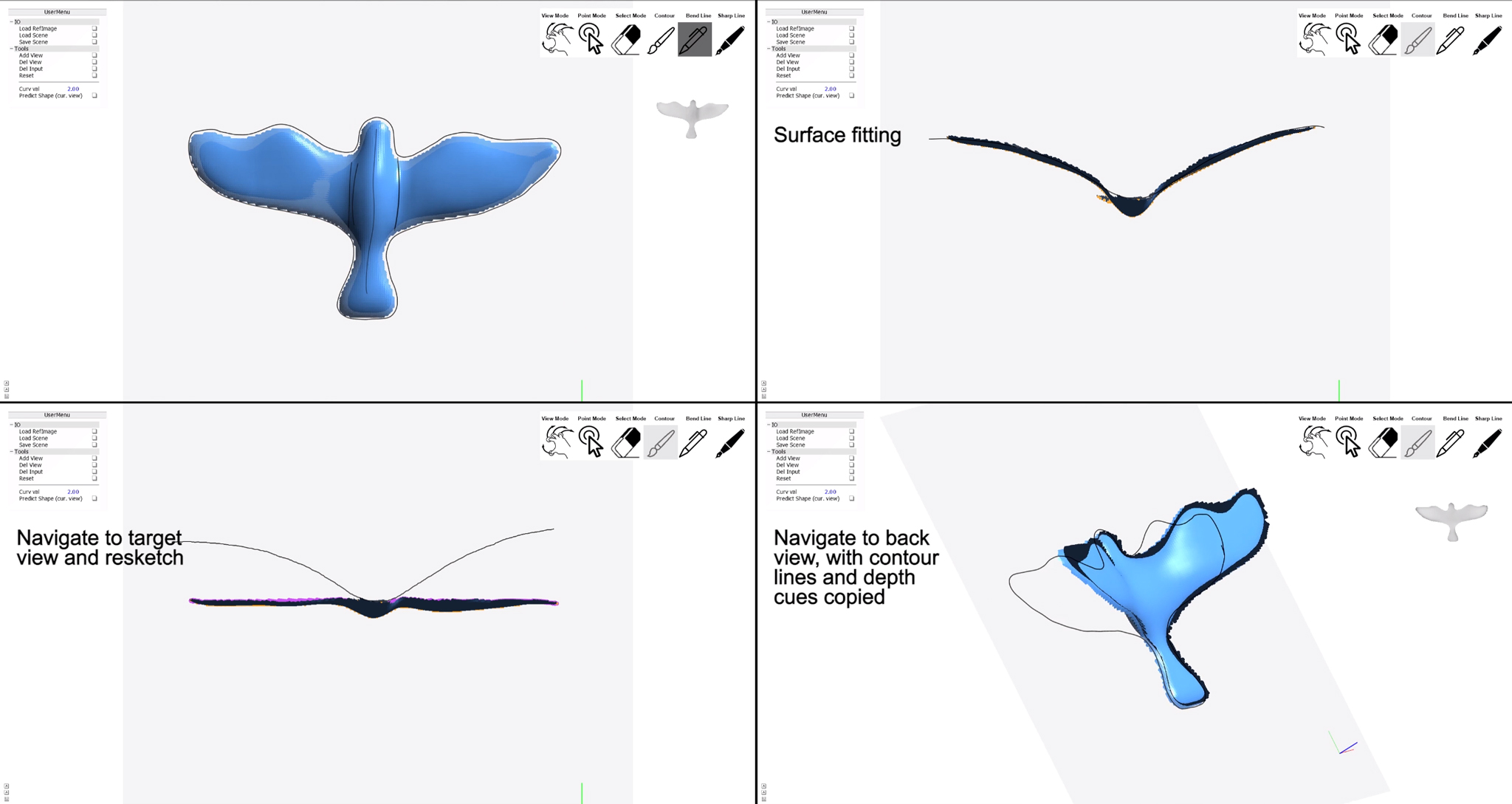

CNNを使用したモデリングプロセスには、シングルビューとマルチビューの両方のスケッチを処理することが可能で、マルチビューフレームワークを使用すると、様々な視点からスケッチを描くことが可能で、ユーザーは任意でポイントの深さ値を指定し、ストロークに応じて曲率のヒントを指定することができ、リアルタイムで完全に閉じた3Dモデルを徐々に完成させることができる。

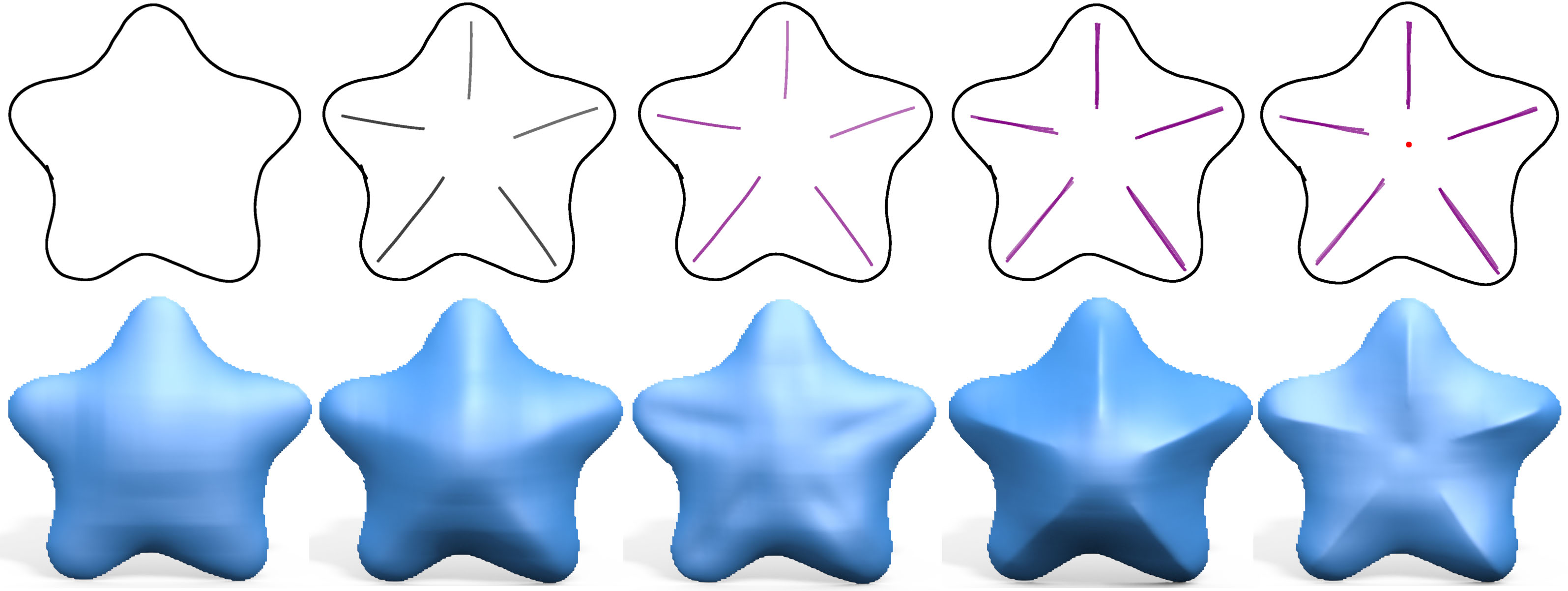

上図左は、モデルのベースとなる輪郭線のみで、右に展開するにつれ内側のストロークが追加(曲率ヒントが描画)されて形状が変化。後半のストロークでは峯部分に鋭角なヒントが与えられ、押上部と押し下げ部(中央の赤い点)による形状の変化が確認できる。

また、上図のように任意のポイントにコントロールポイントを追加し、ターゲットシェイプに沿うように形状を変形させることもできる。

関連記事

- 独自アルゴリズムと3Dプリント技術で簡単にシリコン型を生成

- 動画から3Dプリント可能な3次元モーションデータを生成

- フォーラムエイト国産3DCGソフト「Shade3D」を買収

- お絵かきアプリAutodesk SketchBookが完全無償化

- STL修復ツール18選

- Facebookは新しい3Dモデルフォーマットをサポート

- 3Dプリント解析ソフトウェア「NETFABB」新バージョン登場

- Fusion360操作ガイド「アドバンス編」

- 3Dプリント部品の表面を自動的に滑らかにするマシン発売

最新情報をお届けします

Twitter でid.artsをフォローしよう!

Follow @idarts_jp