- 2015-6-9

- 最新情報

- 3DPrinting, 3Dプリンティング, 3Dプロジェクションマッピング, 3Dモデリング, Autodesk, Kinect, Leapmotion, センサー, テクノロジー, プロジェクションマッピング

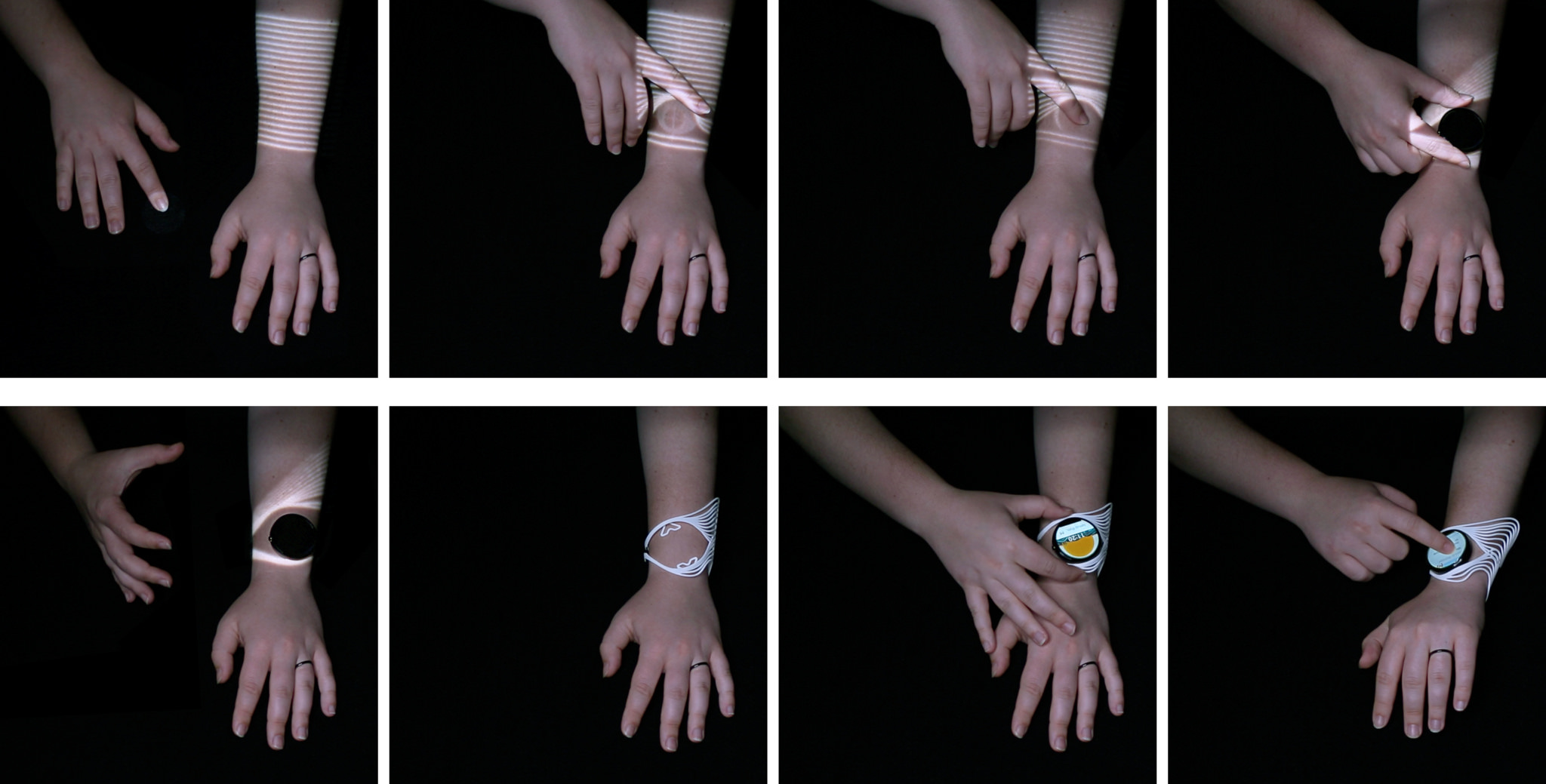

自らの皮膚に投影された映像から3Dモデリングを実行する『TACTUM Skin Based 3D Modeling』

Autodesk ResearchとMadLabsが共同開発したこの『TACTUM』は、従来の3Dモデリングの常識を覆す、全く新しい概念の3Dモデリングシステム。

TACTUM – Skin-Based 3D Modelingと呼ばれる3Dモデリングシステムは、利用者(モデリング情報を抽出する対象者)の皮膚に直接プロジェクションマッピグ(映像)を投影。

投影された映像に対し、ひっぱたり、なぞったり、ひねるなどのジェスチャーを行うと、その動きに応じて投影映像がリアルタイムに変化。この変化した映像をベースに、身体にフィットした3Dモデルを生成することができるというもの。最小許容値は約20mm

Kinectセンサーとプロジェクションマッピング映像を利用した深度情報の抽出に加え、リープモーションコントローラーによるジェスチャー情報を検出。ちなみに、現在の開発モデルはCASIO製プロジェクターXJA251 を利用して映像を投影しているそうです。

これらのセンシングシステムから抽出された情報を元に、独自のアルゴリズムによって3Dモデルデータを生成。生成された3Dモデルデータを利用し、様々なタイプの3Dプリンターで造形が可能。

デモとして公開されている作品からは、モト360スマートウォッチのヘッドに合うウェアラブル用バンドの事例を見ることができます。デモ作品ではシンプルな線描によるモデルとなっていますが、今後投影する映像のパターンが拡張されていけば、より複雑なモデルの生成も不可能ではないはずです。

このように、体にフィットした3Dモデルを生成するのはとても難しい作業ですが、従来のような3Dモデリングプロセスを経ずに生成できるこのシステムでは、それらの操作を直感的に実行可能。まさに画期的なモデリングシステムですね。

最新情報をお届けします

Twitter でid.artsをフォローしよう!

Follow @idarts_jp